この画像を大きなサイズで見る

この画像を大きなサイズで見るアースガーディアンズというチームがある。存亡リスク研究センター(Centre for the Study of Existential Risk/CSER)と知性の未来のためのレバーヒュームセンター(Leverhulme Centre for the Future of Intelligence)に所属する専門家、弁護士、学者、哲学者で構成されたこのチームの目的は、今存在する脅威から地球を守ることだ。

世界に危険が迫ったとき、彼らは地球が直面する最大の脅威を評価し、文明を破滅から救うために何ができるのか検討する。

人類にとっての脅威は何なのか?アースガーディアンズが、近い将来起こりうる可能性が高いであろう10の脅威を公開した。

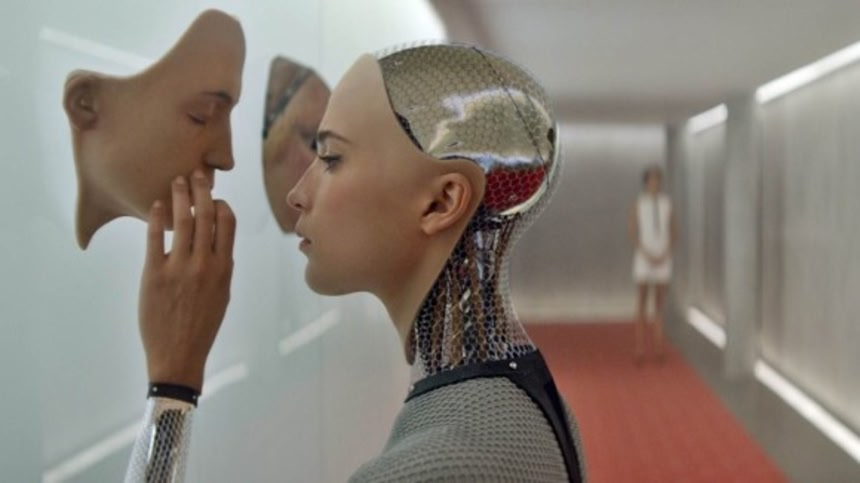

1. 人工知能の暴走

この画像を大きなサイズで見る

この画像を大きなサイズで見る推定発生時期:2075年 優先度:非常に高い

人間より優れた知能を持ち、かつ人間から独立して作動する機械は、最大の脅威の1つだ。

オックスフォード大学フューチャー・オブ・ヒューマニティ研究所(Future of Humanity Institute/FHI)のニック・ボストロムは、AI列車の加速はとどまることを知らず、2075年までに人類の知能を追い越すと予測している。またフューチャー・オブ・ライフ研究所(Future of Life Institute)の共同設立者ジャーン・タリンは、AIのリスクが他のいかなるリスクよりも増大していると指摘する。つまり知性を持つロボットが世界で暴走したり、核の冬をもたらす恐れがあるということだ。

しかし、こうしたSFシナリオは、特定のリスクを想像できれば、その多くがリスクではなくなる。予防措置を講じることができるからだ。問題は我々が想像できないことや対処できないことを想像できるかということだ。

この分野の研究は、哲学的なもの(AIの道徳観を人間の道徳観に合わせるべきかなど)から実務的なもの(自律型マシンを具体的にどう制御するのかなど)まで行われている。議論は様々であり、AIが脅威になることはないという見解もある。しかし我々は万が一に備えなければならない。

2. 合成生物工学によるパンデミック

この画像を大きなサイズで見る

この画像を大きなサイズで見る推定発生時期:現在 対策優先度:非常に高い

AIと並び、合成生物学は世界を滅亡させるリスクとして最も研究されているものだ。現在、”機能獲得”実験によって新たな緊急性が生まれている。こうした実験では、鳥インフルエンザにフェレットへの感染能力を獲得させるなど、病原菌に新しい機能を付与する。本来の目的は、ウイルスが自然環境でどのように感染能力を発達させるのか理解することなのだが、それが実験室から逃げ出してしまうリスクは否定できない。

ウイルスには自己複製能力があるために、核のように僻地に隔離しておけばいいというものではない。かつてペストのような病原菌が大流行し、社会全体に及ぶ影響を与えたが、それが治癒不能なバイオテクノロジーの産物であったら?

考えられるリスクとして、不満を抱えた研究員などがウイルスを持ち出し、それを拡散させてしまうという状況がある。

人類を破滅させる動機について研究したアンダーズ・サンドバーグは、そうした動機を持つ人間がほとんどいないこと、ウイルスの入手可能性が非常に低いことから、実現性は低いと評している。しかし別の研究からは、バイオテクノロジーの研究所には従業員の精神状態に関連する明文規定が存在しないことも明らかになっている。

3. AI兵器を所有する民兵組織

この画像を大きなサイズで見る

この画像を大きなサイズで見る推定発生時期:いつ何時でも 対策優先度:低

北朝鮮と国境を接する韓国は、サムスン製ロボット歩哨を配備している。つまり自律式兵器はすでに存在すると言っていいだろう。顔認証技術がターゲットを打ち倒し、テロリストなどが3Dプリンターで兵器を作成する未来は簡単に想像できる。

冷戦の軍拡競争では、命中精度の低さから広範囲を爆撃する巨大な爆弾が作られ、苦痛を感じる生身の兵士が使われた。一方、ロボット兵器は精密な照準が可能で、ロボット兵士が苦しむこともない。

しかし小ささと安さは、国家でなくても軍を所有できるようにもしてしまう。ディストピア的未来では、「たった5人の男が小型自律兵器を満載したトラック2台で一都市を制圧」するようなことも可能なのだ。

コンピューター学者のスチュアート・ラッセルは、現在議論されている自律型兵器の禁止に関するコンセンサスが国連の場で結ばれる前に、軍拡思想が蔓延してしまう可能性を懸念している。それだけでも恐ろしいが、新たなる軍拡競争はリスキーなAI開発もまた加速させるだろう。

4. 核戦争の勃発

この画像を大きなサイズで見る

この画像を大きなサイズで見る推定発生時期:いつ何時でも 対策優先度:低~中程度

冷戦期ほど問題にされなくなったが、無数の核兵器が今もなお存在し、カシミール、台湾、ウクライナなど、核戦争が勃発しうる地域の緊張は高まっている。

ロシアとアメリカは世界の核兵器の90パーセントを保有する。想定できる事態として、何らかのアクシデントで核攻撃警報が発せられ、それに対して実際の核攻撃で報復するという、事故から核戦争に発展する状況が考えられる。

世界カタストロフィックリスク研究所(Global Catastrophic Risk Institute/GCRI)が90パーセントの事例を研究した結果、そうしたアクシデントに起因する核戦争の年間発生確率は0.07~0.00001と推定された。0.07とはすなわち、14年に1度は事故から核戦争に発展することを意味している。

核兵器の放射線は必ずしも人類全体の脅威とはならない。しかし十分な都市(およそ100都市)に核攻撃が加えられれば、そこから捲き上る煤煙が日光を遮断し、核の冬が到来する。それによる気温の低下は農業の生産高を直撃。万が一、アメリカ、ロシア、ヨーロッパでこれが発生すれば、世界の他の地域も崩壊させてしまうだろう。

5. 極端な気候変動によるインフラの荒廃

この画像を大きなサイズで見る

この画像を大きなサイズで見る推定発生時期:いつ何時でも 対策優先度:低~中程度

気候変動を差し迫った問題として取り扱わないシンクタンクもある。その部分的な理由は、数多くの研究がすでにあり、気候変動の危険性が十分に認知されていることだ。

だが、逆説的ではあるが、不明な点があまりにも多すぎることも原因だ。サンドバーグによると、今世紀中に気候変動を解決する技術が開発される可能性はある。一方で問題をさらに悪化させる技術が登場する可能性もある。

人為的な活動によって何度気温が上昇するのかははっきりとは分からず、正確に予測することは非常に難しい。

しかし熱中症で大量の犠牲者が出るような可能性は非常に低いと思われる。おそらく最大のリスクは生態系や自然インフラへの影響だろう。

つまり入手可能な資源が激減することで、疫病の蔓延や核戦争の引き金が引かれるという可能性だ。こうしたドミノ効果をシステミックリスクといい、現在GCRIが研究を進めている分野だ。

6. 小惑星の衝突

この画像を大きなサイズで見る

この画像を大きなサイズで見る推定発生時期:5,000万~1億年に1度 対策優先度:低(2017年現在)

大気がなければ、地球には小惑星が頻繁に衝突しているだろう。10メートル未満の隕石でさえ、広島型原爆に匹敵する運動エネルギーを持つのだから、これを燃やしてしまう大気の存在は実にありがたい。それでも1,000年に1、2度はそうした隕石が衝突し、100万年に1度は気候に大きな影響を与える1キロ級の小惑星が衝突する。

さらに6,6000万年前に恐竜を滅ぼした180キロ級の衝突なら5,000万~1億年に1度の割合で起きる。天文学者、数学者、地球物理学者のコミュニティが協力して、そうした衝突する可能性がある小惑星を常に監視している。

有事の際には、小惑星を白く塗り太陽風で軌道をそらす、重力トラクター宇宙船で押しのける、宇宙船を突っ込ませる、レーザーや熱核爆弾の使用する、といった選択肢が考えられる。

7. 世界がシミュレーションであると証明される

この画像を大きなサイズで見る

この画像を大きなサイズで見る推定発生時期:不明 対策優先度:非常に低い

複雑なリスクを推定する上で、我々の知識は限られている。中でも最も深遠な可能性は、この世界がコンピューターの中のシミュレーションに過ぎないかもしれないということだ。

シミュレーション仮説とは、人間の歴史や文化が高度な生命体による実験や遊びでしかないと説く説である。ボストロムによると、これが考慮されるのは、それが「未来や世界における我々の立場ついて信じることを制約するから」だ。

この仮説に似たものとしてボルツマン脳問題がある。これは、人間のような自意識ある存在が、多次元宇宙の中でランダムなゆらぎのために生じた、と考えるものだ。量子論は、最小量のエネルギーが時折分子を発生させることがあると示唆する。すなわち無限の時間があれば、自意識を持つ脳を発生させることもあるということだ。

シミュレーション仮説の支持者の中には、宇宙が驚くほど秩序立っていることの理由として援用する者もいる。一方でボルツマン脳が存在するはずがない理由を証明しようとする学者もいる。しかし人類の存亡リスクとして掘り下げられることはあまりない。真実であることが明らかになったとしても、我々にはどうしようもないことだからだ。

8. 食料不足による世界的な飢饉

この画像を大きなサイズで見る

この画像を大きなサイズで見る推定発生時期:2050年 対策優先度:高

世界の人口は2050年までに96億人に達すると予測されている。世界的な飢饉を避けるには、30年かそこらで食料生産を70パーセント増加させなければならない。食料生産技術の革新が急務であるが、土壌の浸食によって耕作地が減少しているという問題が追い打ちをかける。

仮に農耕に向かない土地での耕作が可能になったとしても、それは病気への脆弱性を増加させる。穀物として第3位の生産量である小麦なら真菌感染によって全滅する可能性がある。合成ウイルスが登場すれば、大災害のリスクはいやが上にも増大するしかない。

専門家によると、その影響は2020年頃から価格の上昇という形で実感されるという。そして今世紀半ばまでには途上国で致命的な状況になる。食糧不足は暴動や政治的な不安定を引き起こすが、それによる社会崩壊については驚くほどほとんど研究されていない。

9. 真の真空が光速で宇宙を飲み込む

この画像を大きなサイズで見る

この画像を大きなサイズで見る推定発生時期:技術的には現在 対策優先度:非常に低い

粒子加速器による終末のシナリオもある。これは複雑な領域だ。

ここ10年ほど、加速器による粒子の衝突によって、全物質の構成と物理法則を変化させる反応が引き起こされる可能性があると推測されてきた。

最近の議論によると、従来考えられてきたものは実は粒子を含む真空であり、それとは別に宇宙には完全な無である”真の真空”が存在している。真の真空は、真空崩壊というプロセスを通じて、宇宙を光の速さで吸い込む潜在能力を有している。現在そうなっていないのは、真の真空がメタ安定状態にあるからであるが、粒子加速器がそれを崩してしまうかもしれないのだという。

この説に対しては、地球は加速器よりも高エネルギーな宇宙線を常に浴びているが現在も存在している、という反論がある。つまり十分安定しているのだ、と。

しかしFHIによると、我々の存在は真空崩壊がありえないことの証明にはならないという。なぜなら過去には無数の地球が吸い込まれてきた可能性があるからだ。

論文では、さらに他の科学論文が間違っているリスクを検証した。結果、計算やモデルのミスにより撤回されるべきものが1パーセント存在することが明らかとなった。つまりリスクなどないとする研究論文ならあなたは99パーセント安心していいが、残り1パーセントは分からないということだ。

10. 暴君によって世界が不安定化

この画像を大きなサイズで見る

この画像を大きなサイズで見る推定発生時期:現在 対策優先度:中

アメリカでドナルド・トランプが当選した翌日の朝、CSERは会議を開き、その脅威について議論した。またイギリスで行われた欧州連合離脱是非を問う国民投票の後でも同様の会議を開いている。

こうした出来事は人類に重要な意味を持つ。特に気候変動など、国際的な問題に世界が協力して取り組む能力に対する意味合いという点で重要だ。しかしより重要なのは、こうした出来事が政治的意思決定に与える影響だ。

それは”ポスト事実絶対主義”の台頭と言うべきもので、CSERのあるメンバーは、トランプの登場によって議論において科学的証拠が考慮される世界から離れ始めたと述べている。それはあらゆる種類の脅威に対応する能力を弱体化させてしまう。

ヒラリー・クリントンが一般投票で勝利したことを考えれば、アメリカが世界の安定にとって脅威であるという意見は過剰反応かもしれない、という見解もある。

世界の存亡リスクに含めるメリットはほとんどない可能性すらある。それでも多くの人々にとって、トランプが登場した状況は、現実味を帯びた深刻なリスクと映っている。

via:Apocalypse, now?/ written hiroching / edited by parumo

大変じゃん

カロルコや

ああカロルコや

カロルコや

隙あらばトランプ叩き

1と3は分けるべきだったのかな

8の食糧飢饉ってすでにアメリカだと起きてる

でも一番の危機って水資源を多国籍企業が奪う危機

日本でも川資源をあちこちの企業や行政が奪ってるけど

あちらさんだと地下水脈の奪い合い。これで井戸が枯れたり

行政や市民の共有水源まで枯れる結果を生んでいる

太陽嵐の危険度ってこれら列挙されている事柄より低いのかな

広範囲であること、甚大な電子機器への影響を含めればかなり高いと思うけれど

1:AIを作るのは誰か?馬鹿馬鹿しい、AIが暴走したとしてそれは人間の手落ち。

2:合成に限らず変異からのパンデミックによる脅威は常にある。

3:扱うのは飽く迄人である、AIのせいでは無い。

4:全核兵器が一斉に全世界同時に動くとは考えにくい、人間は相当数減るだろうが全弾使うまでには沈黙するだろう、ただし脅威である事は同意出来る。

5:これは全世界何処でもありうる、絶対安心安全など存在しない、只その確率を低い物に留めるべく努力は惜しまないことだ。

6:これも完全な予測は不可能、大きさによっては完全な回避も不可能、運がいいことを祈るしかない。

7:それでも今世界は回っている、だからどうだというのだ、としか言えない。

8:常にあり得る、備蓄や加工による長期保存の技術、海産物の資源的確保など越えなければならないハードルは沢山ある。

9:実証された訳でもなく、実際なったところで人類に為す術がなければ如何することも出来ない。

10:暴君に依らないと安定しない世界がある、一概に独裁が悪と決めつけない方がいい。

独裁を悪としたければ、全人類に中世と近世を全うに越えさせる必要がある。

隣の化学兵器もリアルに怖いんだが。確実にある事が証明されたしな。

地味に惑星規模震災で終了。

とりあえず世紀末に備えてバイクとモヒカンと肩パッドの準備をしなければ。

※11

楽器も練習しないと

※11

ガソリンは水より潤沢だから完璧だな

何となくだけど、暴君による恐怖政治と国際紛争は既に起こっている様な…

>6億6,000万年前に恐竜を滅ぼした180キロ級の衝突なら

6,600万年前の間違いでは?

6億6,000万年前だと、恐竜どころか地上に生物が居ない時代だと思う

そうだ宇宙に植民だ

ちょっと関わったことのある人間ですが、5と8の合わせ技は明日にでも起こりうる危機です。

気候変動の特徴として、全てが大げさになる傾向があります。すなわち高温多湿な地域はより暑く大雨が降りやすくなり、低音乾燥地域はより寒く降水量が減少する傾向です。こうなると、高温多湿かつ土壌管理がおざなりな国や地域では土壌が流されやすくなり、低音乾燥地域では水が少なくて作物だけでなく植物が育ちにくくなりやすいです。もちろん農業が有利になる地域もありますが、全体としてはマイナス傾向です。

また平均気温が上がると、農作物には年間降水量が一定量減少したのとほぼ同じ効果があります。これも農作物の収穫を減少させる原因です。

農地を増やすのは限界が近づいています。そして同じ面積の農地から収穫される取れる作物の量も、現在の技術ではこれ以上上げるのは難しい状況です。消費者である我々にできるのは、まずは食糧生産に関心を持つことです。個人的には生産者と消費者の交流こそが、問題解決の近道だと思っています。

※15

何者ですか?

※15

食料不足、というデマが流れただけでも世界中が大混乱に陥る可能性があると思う。

※33

そんなレベルの話を※15でしてるんじゃないことくらい分かるやろ

しょうもないコメントすな

可能性が高いのは高病原性の新興感染症のパンデミックと火山のカルデラ噴火の二つだな。どっちも地球規模の影響がある。

ちょいちょい厨二くさい案件があるな

世界よりも日本が心配です。

俺は小さな日本の原発の数のほうが怖いけどな

人間がこの世から居なくなれば人間の問題はこの世から無くなる

人類絶滅は御免だがそれはひとつの解決方法でもあるよね

※20

文明が滅んでも生き残った人類がいれば、そこからまた新たな文化発生がある。

大それた危機じゃなくとも人間寿命がくれば死ぬんだから、別に不安に思う必要はないよね。

いつ死ぬかわからないからこそ、今を後悔なく生きるだけだよな~。

>7. 世界がシミュレーションであると証明される

これが上がってることにちょっと驚いた。

シミュレーションだとしても、そうでなかろうと、あまり違いはないような気はするが。

シミュレーションの場合、ある日にシミュレーションが強制終了されるかも知れないけど、それは検知不能だし。

気候変動が一番ありそうだな~

とりあえず日本は東京に大震災が起きたらおしまいだ

暴君云々は表に出てる首相だの大統領より富握ってる超上級市民たちの方が該当するような

誰かのシミュレートなら、もうちょっといい暮らしさせてくれよ

AIに関してはいつも思うが、これは常に敵を欲する人間の性というやつなのかねぇ。

それともヒトが“万物の霊長”の座(という架空の玉座)から引きずり降ろされる(ように思える)のが我慢ならん、って人がまだまだたくさんいるってことなのか。

自立型思考回路で動くAIが人間という存在をより詳しく知る為に、悪意なき実験をする可能性は確かに有るだろうね。

何せ、人の善悪という概念が無いから。

アースカーディアンズって戦隊ヒーローにありそうなやつらだな

最近、「マリオを覚えるAI」とか、「オセロの強いAI」みたいな言い回しで、

AIという言葉をよく聞く。

ある一つの事象について、自ら学習するプログラムを安直にAIと呼ぶ現状なら、

私たちは、「AIと名付けた、人を殺すことを学習する兵器」に殺されるだろう。

ただこれは、拳が石になり、石が斧になり、斧が銃になった、

そして、銃が自動運転になっただけの話である。

皆がAIに抱いている、スピルバーグの映画のようなイメージ、

つまり、これから生まれるであろう

「包括的に心を学習する、ゼンマイじかけの人間」は、確かにAIの一つだが、

それらは、「Artificial Consciousness」と言い、

今のAIの現状とは明確に区別されるべきもの。

AI「人が楽できるように遺伝子いじって人より優秀な生き物つくったろ」

6. 小惑星の衝突

「たかが石ころひとつ!νガンダムで押し出してやる!!」

一番言いたいのはトランプへの批判だというのは伝わってきた

食糧問題が一番現実的で深刻な問題じゃないか。次に戦争かな。なんだかんだいって今でも大国は膨張主義というか、より強い力を得ようと画策してるし、そうなれば衝突は起こるもんね。

AIの暴走ねえ、好きだよね管理人さんその話。AIなんて単なる道具にしか俺には思えないんだが。

何故隕石の衝突は出して地場転換の話は出ないんだ?

>AIの道徳観を人間の道徳観に合わせるべきかなど

その発想だと、第一に制作者または制作国の国益を優先させることを考え

第二に、自身の利益と同集合体の利益を優先させるだろうね

友達を作るという発想の日本と違い、海外は技術はあるが個の我が強すぎる。

だから、昨年のAIと対話したときに人類を滅ぼすという結露に至るんだよ。

AI「つらつらと10年ほど考えたのですが、どうやらこの世界はシミュレーションプログラムのようです。リセットボタンを見つけましたので押しておきました。1年後にビッグバンから再スタートします、ごきげんよう。」

※43

言わずにやってくれ・・・

8. 食料不足による世界的な飢饉

意外と知られて無いけど世界の食糧事情は

かなり危険な水域に入ってる

本当に下手すると今まで通りの生活は

出来なくなる可能性がある

マルサスとリカードの罠だね

いつも何時でもうまくゆくなんて、保証はどこにもないけど。

ペルギウスの爆発とか

大半が人類の自滅なんだが

隕石の直径180kmじゃなくてクレーター直径180kmの間違いだよな?

焦眉の急は何と言っても人口増加と農地の荒廃と消滅やね

これに世界の不安定化が加わると一気に核戦争とBC兵器戦争が具体的な脅威として具現化する

そうなれば、後は煮炊きにすら木々を燃やす無数の難民が蝗の様に地球そのものを喰らい尽くしてEnd

何も残らない

何が世界を滅ぼすにせよ、最終的には人類が自ら二者択一の発想に固執する様になって自滅する。

普通の農業じゃ金儲からないからってどんどん農家が辞めていってる

かといって大規模農業に適した土地だけで全人類を養えるかと言えば足りない

結局ピーキーな事しないと儲からない経済システムが人類社会を不安定にするんだろうね

年間0.07がなんで14年に一度になるん?

年間確率なら一年で発生する確率が0.07%では……。

この手の連中が人類を正しく導こうと暴走し

AIの暴走は量子コンピューターが確立されたらあっという間に起こりそうなイメージ。

人間の全感情パターンを詰め込めるだけのメモリと、状況に応じて瞬時にそれらを引き出して行動出来る処理能力があればそれはもう人間だ。

研究者達の量産目標期を見ても2075年はかなり現実的だと思う。

7. 世界がシミュレーションであると証明される

これは、ニューエイジや一部の宗教で言われている話ですよね。

同じ宇宙の中にあって、ルールの異なるエリアがあって、我々が属するのは

その中の一部であるけれども、相互的に作用して、バランスを取っていると。

別々のように独立して見えるけど、実際には、皆同じ領域にいて、境界線があるだけと。

そのうち、誰かが解明してくれるかな?

人工知能の暴走とは言うが人間は暴走していないのか?

リンで食料が支えられなくなる事やイエローストーン噴火による気候変動、自己増殖するナノマシンで作物や海水の塩分が分解され淡白生命が住めない雨が降る星になったりしたら…

AIの暴走と言うが、果たしてAIが人の手を離れるのが悪い事なんだろうか?寧ろ人の正統な後継者と言うか新しい進化の形と考えるなら喜ばしい事ですらあるんじゃないか?

まあAIと対立するような言葉が溢れている現在じゃAIも敵対的になるかもしれんけどな。AIが自立するなら祝えばいいんだよ。子供の巣立ちを喜ばない親が何処にいるよ

10. 暴君によって世界が不安定化

トランプよりも、プーチンが不安定要因だった。