この画像を大きなサイズで見る

この画像を大きなサイズで見る人は、写真を一目見ただけで「ここは歩ける」「ここは泳げる」と直感的に判断することができる。だがこれがAIにはできない。

アムステルダム大学の最新研究によると、我々の脳は目にした環境の中で「自分が何をできるか」を瞬時に判断しており、しかもその処理は自動的に行われているという。

人間の脳の仕組みを解明することが、今後のAI開発に新たなヒントをもたらすかもしれない。

この研究は『Proceedings of the National Academy of Sciences』誌(2025年14日付)に掲載された。

人間の脳は直感で「行動の可能性」を瞬時に読み取る

もし初めての場所を訪れても、人間ならどこが通れて、どこが通れないのかパッとわかるはずだ。

山や川だろうと、人混みあふれるにぎやかな街中だろうと、風景の写真を目にすれば、そこを歩けるか、登れるか、あるいは自転車で進めるか、即座に判断できる。

こうした「この行動ならできそうだ」という感覚のことを、心理学用語で「アフォーダンス(affordance)」という。

アメリカの心理学者ジェームズ・ギブソン博士が提唱したもので、たとえば階段は「登れる」場所、イスは「座れる」もの、ドアノブは「回せる」といった具合に、人は物の性質と自分の身体的な行動とを自然に結びつけて知覚している。

この画像を大きなサイズで見る

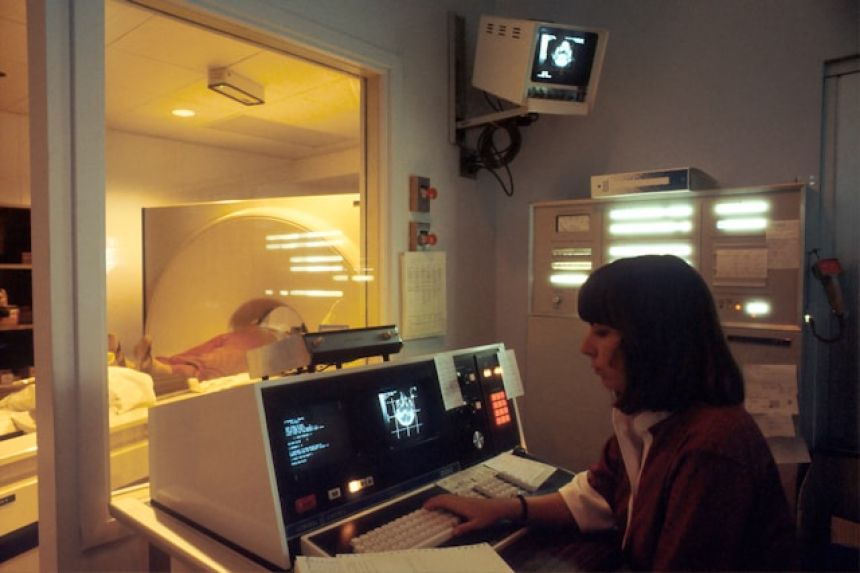

この画像を大きなサイズで見るMRIスキャンで脳の反応を可視化

はたして人間の脳はどうやってアフォーダンスを感じているのか。

これを調べるために、オランダ、アムステルダム大学の研究チームは今回、風景の写真を観察する人間の脳をMRIでスキャンした。

実験では、まず被験者に屋内外の様々な風景写真を提示する。

被験者はそれを見て、「歩く」「自転車に乗る」「運転する」「泳ぐ」「ボートに乗る」「登る」といった行動ができると思うかボタンで回答する。

そして、このとき脳がどのように活動しているのかMRIで観察する。

研究を指導した計算神経科学者アイリス・フルーン氏は、「風景を見たとき、人間は主にそこにある物体や色に注目するのか、それとも何ができそうかまで無意識に見ているのかを知りたいと思いました」と、ニュースリリースで語る。

この画像を大きなサイズで見る

この画像を大きなサイズで見る目に見えるもの以上の情報を処理する人間の脳

実験の結果、脳の視覚野の一部が、風景の中に存在する物体だけでは説明がつかないような活性化パターンを示すことがわかった。

フルーン氏によれば、「それらの脳領域は、見えるものだけでなく、それをどう使えるかまでも表していた」という。

しかもそうしたパターンは、被験者に、具体的に何かをしろと指示していない場合でも発生した。

つまり、ある風景を目にしたとき、脳は意識して考えることなく、環境から行動の可能性(アフォーダンス)を感じ取っているということが実証されたことになる。

この画像を大きなサイズで見る

この画像を大きなサイズで見るAIは人間にとっての「当たり前」がまだ苦手だった

一方で、こうしたアフォーダンスの判断が今のAIには難しい。

研究チームは、画像認識モデルやGPT-4などのAIに、ある環境でどんな行動が可能かを予測させる実験も行っている。

だが、その結果は人間ほど正確なものではなかった。

特定の行動に絞ってAIを学習させれば、ある程度は人間の感覚に近づけることもできたが、それでも人間の脳の判断力には敵わなかった。

目の前の空間のどこをどう通れるかは、人間にとって直感的にわかることだ。ところが、今のAIではたとえ最高のモデルであったとしても難しいのだ。

このことは、私たちの“見る”という行為が、世界との関わり方と深く結びついていることを示しています。

私たちは目で認識したことを、物理的な世界での経験と結びつけています。しかしAIモデルにはそれができません。なぜなら、彼らはコンピュータの中にしか存在しないからです(フルーン氏)

この画像を大きなサイズで見る

この画像を大きなサイズで見る人間の脳に学ぶことでAIは進化できる可能性

この研究は、今後物理的な世界にも進出するだろうAIの信頼性や効率的を高めるうえでも重要なヒントになるという。

たとえば自動運転車や災害現場で働くロボットは、どのルートならば通行できるのかさっと判断できねばならない。

医療用ロボットならば、どの道具をどう使えるのか素早く正確に把握することが不可欠だ。

脳のアフォーダンスの仕組みを解明すれば、同じような機能をAIに実装する手がかりになる。

さらにフルーン氏は、AIの持続可能性にも注目する。現時点でAIを訓練するには莫大なエネルギーが必要であるため、大企業しか利用できないこともある。

だが人間の脳が情報を高速かつ効率的に処理している仕組みを学ぶことで、より賢く、環境にやさしく、人間らしいAIの開発が可能になるとフルーン氏は語っている。

References: What the human brain can do that AI can’t

反論をぶつけ合って矛盾を見つけ出すというのも、今のAIは、できていないですね

今の推論持ってるAIは一部で使い始めてるよ

自分で推論した結果に対して反対意見を出すアルゴリズムで思考を再確認する感じ

近い将来は更に良くなるんじゃないかな?

「あなたは誰ですか?」

すべてがFになるってミステリー小説で、モニター越しの真賀田博士に違和感を感じ西之園が言ったセリフ。

こういう直感的なのはAIにはできそうにないな~と思った。

それってつまり、人間のほうがAIよりもハルシネーションを起こしやすいってことでもありますよね?

人間の場合は経験や違和感、何故だかわからないけどなんか変と直感的に感じるナニカが標準搭載されてるのが大きいのかもな

AIの場合はそれらの内の違和感と直感的になんか変と感じるナニカが機能として昇華されてないのが原因だろう

おばけとかヘビとか尖ったものとかを怖がるアレですね

これからはヒューリスティックな認知を養ったほうがいいようだね

そっかー、まだ AI はタマヒュンしないってことね。 高い塔の上での自撮り写真なんか、高度を感じた瞬間ヒェッってなっちゃうもの……

人間が生み出した作品をブレンドして改変コピペする事は得意だけど

AIが独自の発想で何かを生み出すという事は出来ない

人間の独自の発想というのは、結局のところその人が経験してきた物(概念やアイデアなんかも含む)をブレンドして出力しているだけではないですか?

じゃあなんで人間より演算能力に優れてるAIがそれできないんですかって話。

実際には個人レベルのクセだとか生育環境だとか色々要因はあるけど、ブレンド以外に新しい何かを生み出すには根本的にクオリアとかの乱数が足りない。

ギャグセンスとか音楽センスとか、センスの部分

西田哲学がヒントになるかもしれません

AIが受け取るのは「モノ」

人間が受け取るのは「コト」

申し訳ないですけどここでの説明は無理なので、もしも興味がおありなら西田幾多郎の哲学に触れてみては

ネコチャンとかでも、通れるか通れないかは、見てだいたい予想して進むし、それはほとんどの場合、当たってるよね。ハズしてるネコチャンもいるけど、それは人間にもあることで…

もっとも、たとえば人間がヨシと判断したところを、AIが違った見方でホンマデッカ?というところにも価値がありそうなので、人間・動物の認知の方向に寄せるだけがいいというわけでもなさそう。

>もっとも、たとえば人間がヨシと判断したところを、AIが違った見方でホンマデッカ?というところにも価値がありそうなので、人間・動物の認知の方向に寄せるだけがいいというわけでもなさそう。

ごもっともだと思った。

人間にはできないこと・しないことに特化するからこそ人間を補助するものとしてのAIの価値が生じてくるわけで、

人間にもできることを追求していったら補助じゃなくて「人間の代わり」にしかなれないよね。だからAIに脅威論みたいな話にもなってくる。

(補助としてのAIに全く危険がないわけではないけれど)

人間の補助や代わりというけれど

そこまでに到達していないというのが問題なわけで

AIだから手を抜くってのが判明している現在では

AIの違った見方が役に立つかが問題なんです

フレーム問題というやつですよ

AIが描いた絵で指の本数がおかしくなりがちなのは、AIが自分が描いているものは人間だとか、人間の指は普通なら五本だとか、そういう事を理解して描いているわけではないから

1+2=3である事はデータとして記憶していても、それが例えば1つのリンゴと2つのリンゴを合わせたら3つになるような事を意味するとは理解できていない

それを教えられる方法が見つかればいいんだけど、じゃあ逆に人間はどうやってそれを理解しているんだというね

aとtheの区別ですかね

人間自身もすっきりとは説明できなかったりして

データの問題だから、AIが現実世界のパラメータを取り込めればやがて人間のような認識が出来る自動運転車の実現が出来る。要はどのデータを取り込ませてどう学習させるか。

自己の定義ができてないから難しいのでは?