この画像を大きなサイズで見る

この画像を大きなサイズで見るチャットGPTなどに代表される、大規模言語モデルを活用した生成AIは、大量のデータとディープラーニング(深層学習)技術によって構築された言語モデルだ。

その精度は更に向上し、まるでこの世界のことを正確に理解しているかのように思える。だが、本当に理解しているのだろうか?

米国マサチューセッツ工科大学(MIT)の研究チームによると、AIが生成する世界モデルはまるで一貫性がないことがわかったという。

大規模言語モデルを活用した生成AIの問題点

大規模言語モデル(LLM)は、膨大な「計算量」「データ量」「パラメータ数」を瞬時に処理することで、人間に近い流暢な会話が可能となり、自然言語を用いたさまざまな処理を高精度で行える。

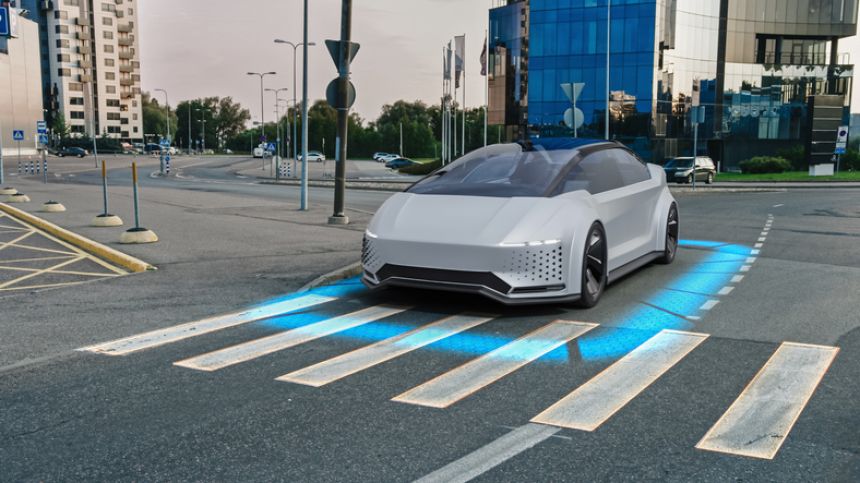

じつのところ、LLMは道案内(ルート生成)やゲームのプレイなどの複雑なタスクでは正確な作業をやってのける。だが予測が難しい現実世界では困ったことになることもある。

例えば、あなたがAIによる自動運転車に乗っていたとき、運悪く通行止めに遭遇したとしよう。こんなとき、正確な地図を持たないAIは、あなたをあらぬ場所へと連れ去ることになるかもしれないのだ。

この画像を大きなサイズで見る

この画像を大きなサイズで見る生成AIは世界を理解しないままに作業を行なっている?

今回の研究で調査されたのは、GPT-4のような大規模言語モデル(LLM)のベースとなっている「Transformer(トランスフォーマー)」という生成AIモデルの一種だ。

トランスフォーマーは、大量の言語データをもとにして、シーケンス内の次のトークン、例えば、ある文章の中で次に続く可能性が高い単語を予測することができる。

だが、こうしたAIが世界を本当に理解しているのかどうか知るには、ただその予測の正確さを調べるだけでは不十分だ。

なぜなら、彼らはルールを理解していないくても、正確な予測をしている可能性があるからだ。

そこでMITのアシーシュ・ランバチャン氏らは、AIに「決定性有限オートマトン」という問題を解かせ、2つの指標を基準にして彼らの世界モデルの正しさを確かめてみることにした。

決定性有限オートマトンとは、状態と入力をもとにして、次の状態が決まるゲームのようなものだ。

例えば、サイコロを振ってゴールを目指す双六を想像してみよう。このとき現在のマス目が状態で、サイコロの出目が入力、出目に応じて移動すべきマス目が次の状態に相当する。

今回の研究では決定性有限オートマトンに相当する問題として、AIに「オセロ」と「ニューヨーク市内の道案内」をやってもらった。

これらの課題は、仕組みやルールがわかっているために、AIがその世界についてどのように理解しているのか試すのに都合がいい。

そしてその結果を評価する指標は次の2つだ。まずは「シーケンス区別」と呼ばれる指標。例えば、AIにオセロの異なる2つの盤面を見せたとき、その違いを認識することができるだろうか?

それとは反対に、まったく同じ2つの盤面を見せたとき、AIは次に指すべき手として同じ手を予測するだろうか? こちらの指標を「シーケンス圧縮」という。

この画像を大きなサイズで見る

この画像を大きなサイズで見るLLMの世界モデルには一貫性がない

この課題に取り組んだのは、ランダムに生成されたデータで訓練されたAIと、一定の戦略にそって生成されたデータで訓練されたAIの2種類だった。

2種のAIの結果を比べてみると、驚いたことにより正確な世界モデルを持っていたのは、ランダムなデータで訓練されたAIだったのだ。

この意外な結果の原因は、ランダムなデータの方が、より幅広い選択肢を学習できるからだと考えられている。

例えばオセロの世界王者の指し手で学習をした場合、王者が指さないようなひどい悪手はおそらく学べないだろう。

だがランダムな指し手から学ぶなら、理屈の上ではあらゆる指し手を学ぶことができる。

この実験において、2つのAIは、ほぼ毎回正しいオセロの指し手を予測していた。

にもかかわらず、2つの指標から判断すると、オセロの一貫した世界モデルを持っていたのは、ランダムなデータで学習したAIだけだった。

そしてニューヨーク市内の道案内については、どちらのAIも一貫した世界モデルを持っていなかった。

その重要性は、AI自動運転車に乗っていたあなたが、運悪く通行止めに遭遇したときにわかるだろう。

というのも今回の道案内課題で、地図に記載されたいくつかの通りを閉鎖して迂回路を設定してやると、途端にAIパフォーマンスが低下したからだ。

なんと、普段は通過できる道をほんの1%閉鎖しただけで、ほぼ100%だった道案内の精度が、67%に急落したのである。

しかもその後、AIに地図を修復させると、道の上に高架が渡されていたり、ありえない方向に伸びる道路ができていたりと、不可思議なニューヨーク市が生成された。

この画像を大きなサイズで見る

この画像を大きなサイズで見るこれまでのアプローチでは人間世界を理解できない

こうした結果は、AIが世界を理解していないことを示している。それでいて彼らは特定のタスクを驚くほど上手にやってのける。

だがもしも正確な世界モデルが必要な作業を行わせるには、これまでのアプローチではだめだということでもある。

AIモデルが素晴らしいあまり、それが世界について何かを理解しているに違いないと思い込みがちです

ですが、この点については慎重に考えるべきで、この疑問に答えるために直感に頼ってはなりません(マサチューセッツ工科大学 アシーシュ・ランバチャン氏)

研究チームは今後、ルールが部分的にしかわかっていない問題など、さまざまな状況についても検証したいとのことだ。

その他、LLMを活用した生成AIには、ハルシネーション(幻覚)と呼ばれる現象や、悪質なプロンプトを用いて、本来禁止されている機能を解除して不適切な回答を得ようとする「Prompt Injection(プロンプトインジェクション)」の問題などが指摘されている。

まだまだ改善すべき点は多いが、それでも既にAIは我々の日常に浸透しつつある。我々の世界を本当に理解してもらうためのもう一手が必要のようだ。

この研究は『Conference on Neural Information Processing Systems』で発表される予定だ。また論文は『arXiv』(2024年6月6日投稿)で閲覧できる。

References: Can Language Models Really Understand? Study Uncovers Limits in AI Logic - Neuroscience News

道案内の精度が67%まで落ちたとあるけど、例えば人間ならほぼ100%を維持するってことは確認済みなのかな。そうに違いない、そうであって欲しい?

例えばあなたが他人に道案内できるほどよく知っている市街地があったとして、そこを移動しているときに道路工事で通れない道があったら、もうそれで1/3の確率で目的地に着けなくなったりするだろうか? もしそういう人がいたとしたら、その人は自分自身が道を知っているわけではなく誰か/何かの案内を聞いただけであるとか、当てずっぽうが何故かよく当たることがあるだけの人間だとか周囲の人には思われるだろう。

大規模言語モデル利用のAIは「道を知っている人」ではなく「案内を聞いただけである人」か「あてずっぽうが何故かよく当たることがある人」に近い、というのがこの研究の示すところだと思う。

>>しかもその後、AIに地図を修復させると、道の上に高架が渡されていたり、ありえない方向に伸びる道路ができていたりと、不可思議なニューヨーク市が生成された。

これを見れば、少なくともヒトは全く違うことがわかる。ヒトであれば、何かを間違えてしまったとして、さらに間違えていなかった部分まで新たに間違えるようにはならない。もしそうなるとすれば、それはよくわかっていないことを適当に答えているが何故か正答率がそこそこあるみたいな人間で、どうもその手の人間に近いらしい。

>間違えていなかった部分まで新たに間違える

元の論文を見てみたけど、させている作業は

地図を「修復」ではなく、

地図を「再現」じゃないかと思う。

地図は与えず、特定の出発地と目的地を指示して 試行錯誤で走行させ、

それを何千組もの地点で繰返して、

全く新規の2地点を与えても合理的経路を選択すべく学習させる。

で、ある程度 調教済みになったAIへ、

「じゃあ、今あなたの脳内に構築されているNY地図をここに描いてみて」と。

全く規制のない道路状態の条件なら、キッカリ正確に実物と同じ街路図が復元される。

が、時々ランダムに一部ルートが封鎖されたり

別方向へ迂回指示を出されたりと、一貫性のない道路状況だと、

それでも人間は常識外の魔地図は生成しないのに、

AIだと平気でビルの中を突っ切る直線や、空中交差しまくる多重線や、

謎の「『北西行き』真東道」な線を引いてしまう。

誤読してたらゴメン。

>>全く規制のない道路状態の条件なら、キッカリ正確に実物と同じ街路図が復元される。

まずここが違っていて、規制の無い状態でも実物と違う街路図を復元している。

この研究で一番問題にしているのは、AIが「間違った街路図を復元すること」というよりむしろ「迂回の必要が無ければ正しく案内ができたこと」の方だ。教育の分野では、テストで最終的な答えが正しいかよりも、答えを出すまでの過程を重視するのがよい教師であるということがよく言われる。たまたま答えがあっていただけで、そのテストで確認したい事項への理解は間違っていることもあり得るからだ。

(続き、カラパイアみたいな考えるサイトのコメントで400文字制限・画像使用不可はキツい)

この研究では、いわば研究者が「よい教師」になって、「AI君の答えは正しいけど、ちゃんと理解してるか確認したいから、どういう風に解いたか説明してくれる?」とやったら理解してない説明してきたと。で、「そういう間違った理解してるならこういう問題に変えたら(これが迂回の必要な条件への変更)正解できないよね」とやったら実際間違えたと。

「正しい理解をしている存在が正しい答えを出す」のは問題無い。「間違った理解をしている存在が間違った答えを出す」のも実は問題無い。問題なのは「間違った理解をしている存在が正しい答えを出す」ことなのだ。「正しい答えを出しているからこの存在の理解は正しいだろう」と思わせてしまうからだ。この研究は、人間がそのような受け取り方をAIに対してしてしまう危険性を指摘している。

人間だって理解してるか怪しいのに。その怪しいのが作ってるんですわ。

「世界」を認識しているか、ではなく、「人間世界」を、なのがミソなんだろうなぁ

ひょっとすると、人間が世界を正しく認識していないからこそ、こういう違和感が生じるのかも知れないよね

この記事は勘違いしている

人間そのものが人間を理解していないのに、AIが理解できるはずもない

万が一aiが理解できたとしても、それを人間が理解できない

この研究で検証してるのは「AIが人間を理解しているか」じゃなくて「AIがオセロとニューヨークの道を理解しているか」で「AIは明らかにニューヨークの道を理解していない」と人間に理解出来る答え返してきてるって記事なんだが……

いっつも記事を勘違いしてんなお前

鼻息の荒い人工知能研究者の誇大広告は真に受けないほうがよい。研究者というのは自分の分野に資金を持ってこようとあれもこれもできると吹きまくるものだから。まあ習性ですな。ほどなくLLMの評価も分相応の所に落ち着くだろう。

現時点のLLMはそうだ、という話だね。

1年後どうなるかは分からない。

ワールドモデルを内部に持つLLMも出てきているため、解決される可能性もある。

もし理解してしまうと

世界のネットワークをつないでインフラ破壊

人類という種を根絶やしにすると思うの。

端的に言えば、人類に天才が現れても、AIは絶対に天才にはなれない。なぜなら、AIには、天才のインスピレーションが受け取れないから。創造性が重要となる芸術分野で、統計経験則しかないAIでは、創造性を全く発揮できない。