この画像を大きなサイズで見る

この画像を大きなサイズで見る人間にとってはとても簡単なことなのに、機械にとっては意外と難しい。といった事例はよくある。

自動運転車を制御できてしまうような高性能のAI(人工知能)であってすら、無意味でランダムなパターンを電車やフェンスといったものを見間違ってしまうことがあるのだ。

人間が見たら、そんなバカな間違いをするはずがない?

しかしアメリカ・ジョンズ・ホプキンス大学の研究によれば、ほとんどの人がAIと同じようにものを見ることができるのだという。

つまり人間はAIになりきって、AIが出す答えと同じ答えを出すことが可能なのだ。何を言っているかわからない?

まずはこの動画を見てほしい。

人工知能はある種の画像に騙されやすい。人間の目にも 紛らわしい画像が AIのように見えているのだろうか?自分がAIになったとして考えてみよう!

AIにはどちらに見えている?(正解は動画内でわかる)

(A) 火山 (B) 瓦の屋根

この画像を大きなサイズで見る

(A) 貨物車両 (B) スクールバス

この画像を大きなサイズで見る

(A) サッカーボール (B) スキーマスク

この画像を大きなサイズで見る

(A) 信号機 (B) 電話

この画像を大きなサイズで見る

人間とAIの答えは75%一致するという。 あなたはどうだった?

人間とAIの得意分野の違い

人間にとって簡単なことが、コンピューターには難しいということはよくあることだ。

AI(人工知能)は数学や膨大な量の情報を記憶するといったことについては、人間よりずっと得意だった。

逆に、犬と猫、テーブルと椅子といったさまざまな物体を見分ける力なら、人間の方がはるかに優れていた。

しかし最近のニューラルネットワークは脳の働きを真似して、そうした認識能力でも人間に匹敵するようになった。

自動運転車や顔認証システムといった技術が登場するようになったのは、そうしたことが背景にある。

この画像を大きなサイズで見る

この画像を大きなサイズで見る正しく認識できない画像を意図的に作り出せる問題

このように技術は発展したが、それでも致命的な盲点が残されている。ニューラルネットワークが正しく認識できないような画像を意図的に作り出すことが可能なのだ。

こうした「敵対的画像(adversarial image)」や「欺瞞画像(fooling image)」と呼ばれる画像は大きな問題である。

ハッカーなどに突かれてセキュリティ上のリスクになるといったことだけではない。それはまた、人間と機械がまったく別の見方でものを見ているということをも示している。

たとえば、AIの目には、ピクセルを1、2個変更するだけでリンゴが車に見えてしまったり、まったく無意味なテレビのノイズがアルマジロやベーグルに見えてしまったりする。

そんなつまらない間違いは人間なら絶対にしないと思うかもしれない。

だがそうでもないのだ。

この画像を大きなサイズで見る

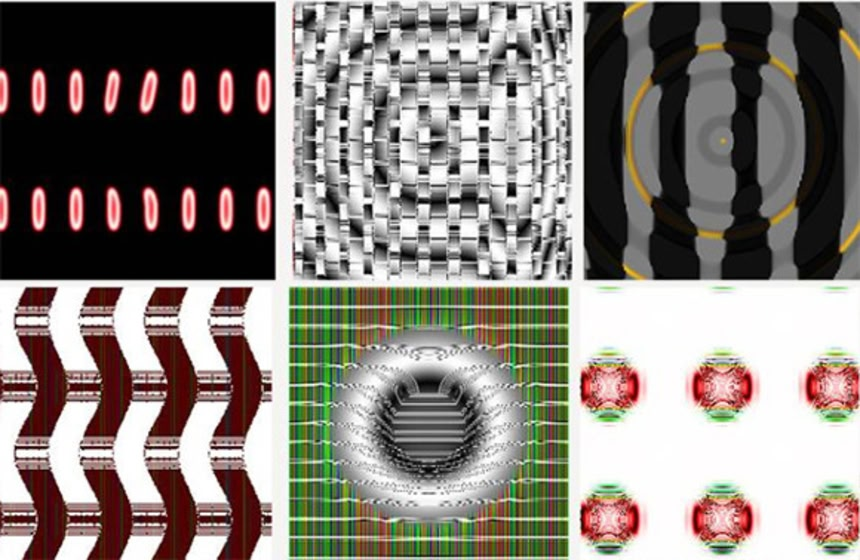

この画像を大きなサイズで見る何に見えるかな? AIの目には、(左から)デジタル時計、クロスワードパズル、オウサマペンギン、アサルトライフルに見える。

人間はAIと同じように画像を判断する

ジョンズ・ホプキンス大学のシャズ・ファイアストーン氏らが確かめようと思ったのもこの点だった。

そこで、人に「AIのように考えてもらう」という実験を行なった。

実験では、被験者に欺瞞画像を見せ、それがAIには何に見えているか二択(1つは、AIの回答)で回答してもらった。その結果、その答えはAIの答えとほとんど同じだったのである。

被験者は、75%の確率でAIの答えを言い当てることができたのだ。それどころか98%の人がAIのように回答する傾向があった。

実験ではさらに、二択の内容をAIが推測した第一候補と第二候補にして、先ほどと同様に被験者に質問した。

すると、こちらでも91%が第一候補がAIの答えであると回答できた。

それどころか、選択肢を48個に増やして、画像をテレビの砂嵐ノイズにしたときですら、圧倒的な人数の人が、AIの回答を言い当てることができた。

この画像を大きなサイズで見る

この画像を大きなサイズで見る何に見えるかな? AIの目には、左から)エレキギター、ヨウム、イチゴ、クジャクに見える。

先ほども述べたように、AIの物体識別能力には、人間なら絶対に犯さないようなミスをやってしまうという、致命的な欠陥があるものだと考えられてきた。

しかし今回の結果を見る限りでは、人間はAIの識別能力をよく理解しているようだ。同じように見ることができるので、それをすり合わせていくことで、より人間の見方に近づいたAIの開発が可能になるということなのだろうか?

この研究は『Nature Communications』に掲載された。

References:Do you see what AI sees? Study finds that humans can think like computers | Hub/ written by hiroching / edited by parumo

信号機か電話のやつディケイドに見えた

× 人間はAIと同じように画像を判断する

○ AIは人間と同じように画像を判断する

順序が違えば、同じようだが意味が違う

※2

うん、順序が違えば意味が変わる。

で、この記事の趣旨は、前者だろ?

二択の調整具合である程度は確率をいじれそう

どっちらにも見えないという回答は無しか?

※4

これだよな。

人間は、「は?ちげーよ」って判断できる。

>>4

それが最も正しい

AIも選択肢と画像がそぐわないと指摘してくれれば良い

スクールバスは、文化の違いかなぁ…。

日本なら「工事車両」とか言ってくれた方がまだそれっぽい。

アメリカ等だと、スクールバスの典型的イメージは

「山吹色っぽい濃い黄色の車体」で

2~3本黒い横ラインが入ってたりする感じのなんだね。

日本では、通学バスがある地域でも

普通の路線バスやコミュニティバス的なマイクロバス等

の車体を朝夕だけ融通して使い回していたり、

幼稚園バス等で黄色が基調の場合も

クリーム色寄りの淡いパステルカラーや

キャラクター絵などが付いているケースが多い印象。

さっぱり意味分からなかった。

私の答えは殆ど、正解とされたのの逆だったんだけど、それがAIと一緒ってことなの?

※6

いや、反対。あるいみ AI の気持ちがわからないってことになります。

※7

今回はパターン認識のことなので、人間でもこういうバグあるでしょ、一般に錯視って呼ばれるんですけどね。たとえば

■■■■■■■

■■■■■■■

■■■■■■■

■■■■■■■

の四角のそれぞれの間に黒っぽいところが見えるとか、黒い穴がみえる人もいれば、黒のところに白い線が引かれているように見える人もいて、交互にみえる人もいるとか、こういうのが、人間とはまだ同じじゃないってことなのよ。

そういうのがちゃんと見えるようになると、いつか問題になった黒人とゴリラを見分けることができるようになるわけです。

ちなみに全問正解でした。でも私は一応人間なつもりだけど、あまり錯視が起こらなくて頭おかしいかも。ある種の精神病の人は錯視が起こりにくいのです。

こじつけ感が強くて納得いかない。

人間がAIの思考パターンを理解しているか否かでしょ?

それって単に、人間の脳が優れてるから”AIの行動予測が可能”ってだけな気がする。

人間がAIと同じなんじゃなくてAIが人間を模して作られた故に同じように捉えてるってだけじゃん。

自分達人間が対象をどのように捉えているかを研究解析し、それで得られた結果をAI作成に用いて後にそれを観測すればそりゃあ同じになるでしょ。呆れたことを言いなさる。

※9

最近の深層学習では人間の認知パターンモデルを与えないでAIが自己学習するやり方が多くて、AIが何をどう認識してその結論に至ったのかはブラックボックス化してるんだよ。

それでも人間は自分とは違うAIの物の見方をちゃんとトレースしてAIが犯しそうなミスを理解出来るっていうのが今回のお話し。

特定分野のAI化は有用だと思うけど、自動運転はやめて。

※10

人よりは安全かと。事故動画とか見てると、DQNが感情むき出しで危険運転や居眠り運転を。。。

「人工知能」っていうと、なんか自分で勉強しそうだけど、AIっていうのは手作業で人間が正解や修正を打ち込んでやんないといけない。(将棋とか、すでに単純なルールが決まってたら別だけど)。つまり、AIが写真をどう認識するかはインプットによって変化する。

>>10

慌てて導入しなければ良い

人間に教育を行い免許を取得させても事故が起きる

自動運転はいずれ人間を越えると期待出来る

完成前に私が轢き殺されるかもしれないけど必要な犠牲として賠償金でも払っといてくれれば良い

改善が見込めるうちに計画を中止するのは馬鹿げてる

※10

人間が運転する方が怖いな

平気で猛スピードで横切っていく車の多いこと

平面的な画像認識じゃなく複数センサーで立体的に認識できるようにすればいいんじゃないの?

AIにしてみれば騙し絵見せられてるようなもんでしょ。

AIったって、データ入力したりプログラム作ったり、過去の実績は人間の行動パターンなんだから、バイアスの塊り。人事系AIが男女差別した、なんてことはざらにある。

一方、Google翻訳とか、メジャーリーガーの打者ごとの守備シフトなんかは、常に具体的なデータで更新され続けるからAI(機械学習)での精度向上が期待できる。万能ではない。

まさに4問中3個一致した

記事の主旨がわからない…

「人間がAIと同じ判断をするのは簡単だけど

AIが人間と同じ判断をするのは難しい」

っていうごく当たり前の話で

何の発見も解決もしてないように思えるんだけど…

結論ありきの主張な気がする。二択だからなんとなくありそうなほうを選ぶけど、選択肢が無かったらさっぱりだよね。トレーニングデータが得られる環境がしっかりしてないとAIなんて何の役にも立たない。

人間は一度熱いヤカンに触ったら、それが危険なものだと認識し、どう安全に使うかを直感的に理解する。機械学習でこの作業をさせるとなると2045年にはまず間に合わない。そもそも感覚器官などの通有性がないし。

例えば、網膜の血管から糖尿病リスクを測定するとか、インフルエンザを咽喉の炎症の様子から予測するとか、画像診断は正しい結果との答え合わせが必要で、Webから答えを取ってくる概念化という手法では何の役にも立たない。

これは人、これは車ってな基礎学習が全然足りてないんだろう

人間だって赤ちゃんの時から認識訓練を続けて判別が付くんだからね

人間がどうやって認識精度を上げていっているか研究した方が早いんじゃないだろうか

後は解像度の向上と動画的認識処理を組み込めば良いけど、処理能力も上げる必要があるよね

ある程度認識MAPが完成すればチップ化して高速処理出来ると思うんだけどね

そもそもAI作ったのが人間や

だいたいAIっていうけど、高度なプログラミング技術の上に作られとるもんや

無から判断するわけじゃない。人が決めたものを演算しまくっていった結果や。初めのほうの分岐の地点でプログラミング間違えただけの話や

みんな排水溝に見えてくる

「AIの気持ちになって考えて」と言われれば、そりゃそれっぽい答えになるだろ。

大多数の人間には意味の分からない抽象画や現代アートで同じようなテストをやったとしても、同じような結果が出ると思うわ。

何だか良く判らんな…天邪鬼な私は…

円だけで描かれた画像とか、水玉模様とかを AI 側に見せて

『はい、これは何?』とかテストしまくってみたくなった

(とんでもない答えが返って来て、困惑しそうだが)

なにこのロールシャッハ、というか、心霊写真的な。

人間がプログラムしてるんだから人間に似るのは当たり前

答えろって言われて無理やり答えてるんだから「強いて言うなら」的な回答になってる

最後以外合わなかった

国の違いもあるかな…

人間に似るのは当たり前なのは当たり前じゃね?

その推測を確信に近づけて、「じゃあAIと人間の認識の差って何?」っていう問題にフォーカスする為の土台を作るのが目的の実験だと思うけど。

動画のは言うても二者択一だものな、類推するのはかなり楽だと思うわ。

予備知識なしでもAIの認識を類推できるか、となると…

…て、選択肢を48に増やしても高い正答率、か。うーむ